Os exercícios taxionômicos, desde sempre, padecem de uma certa imprecisão, mesmo quando se apresentam despretensiosos. Ainda que assim seja, tais exercícios alimentam e dão forma a uma visada analítica, servindo para melhor compreender o objeto de estudo, sempre que tais classificações soem como modo de organização ou critério basilar para tal. Contudo, não devemos compreender as classificações como modos de existência dos objetos/ações classificadas, como se os elementos classificados passagem a existir após sua classificação, observando rigorosamente as características impostas pela própria classificação. De fato, o processo é contrário, as classificações são feitas a partir da existência dos elementos, a partir de determinadas características e não de todas elas. Os modelos são parciais, sempre.

Apresenta-se aqui um padrão taxionômico de que todos os outros buscam por convenção e se apresentam com uma incumbência classificatória para melhor assentar a caracterização e, por conseguinte, compreensão das interfaces computacionais. Desta forma, elegem como princípio o modo de acionamento do sistema via exercício físico-motor, perceptivo-sensório ou por modelos de reconhecimento dos sistemas. Esses três modos de dar entrada de dados no sistema e extrair dados/informações processadas pelo sistema perfazem a lógica que conduz a proposta taxionômica, ainda que se anteveja modos outros de classificação e mesmo a necessidade de se precisar com maior vagar as categorias aqui defendidas.

O exercício também encontra motivação pela vasta denominação encontrada nos textos de referência, sendo em vários casos classificações sem uma orientação clara, aparentemente mantidas por adjetivos ou norteamentos lógicos que assegurem um viés analítico predominante, ou seja, adjetiva-se, mas não se agrupam modelos, não se configurando como classificação, mas caracterização.

Pretende-se, com este exercício, enxergar melhor o que é mais essencial no comportamento das interfaces computacionais: o modo como realizam o contato usuário-sistema. E é com base nesta premissa e sem desmerecer outros e tantos modos possíveis de classificar as interfaces que são apresentadas as categorias aqui definidas.

1. Interfaces físicas

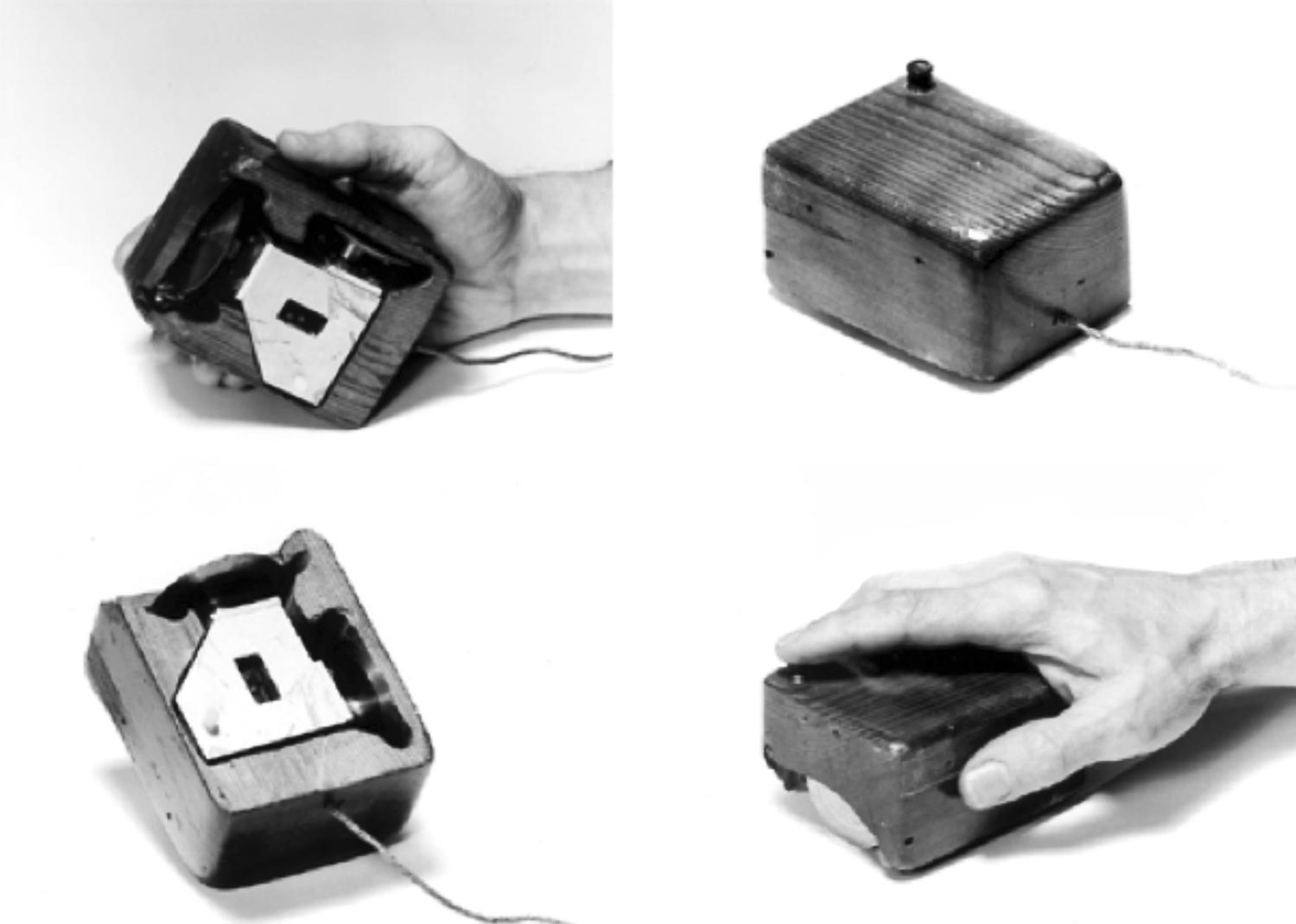

As interfaces físicas foram as primeiras a surgir. Até mesmo antes do Memex, de Vannevar Bush, existem tais dispositivos de entrada de dados para o sistema. As interfaces computacionais da categoria física são caracterizadas pelo acionamento físico-motor realizado pelo usuário. Considera-se físico-motor o dispêndio de energia em deslocamentos pontuais, em superfícies tangíveis de elementos das interfaces, como o que ocorre nos acionamentos do mouse, teclado ou de similares. Há, ali, uma breve movimentação dos elementos físicos, causados pelo empenho de força relativa, ainda que mínima, para deslocamento destes elementos. Fazem parte desta categoria o mouse e o teclado, canetas de marcação que necessitam de pressão física e possuem elementos que se deslocam. São eles: joysticks de videogames, em suas diversas formas de apresentação, e demais dispositivos físicos com a função de entrada e saída de informação na relação usuário/sistema. Se alavancas e botões formavam no princípio dos sistemas computacionais os mecanismos de alimentação de dados, foi na década de 1960 que o mouse surgiu, inventado por Douglas Engelbart para possibilitar a manipulação de dados no espaço-informação da interface gráfica computacional. Ele era parecido com um tijolo, em formato e dimensão, e foram necessários cerca de dez anos para que ele tomasse a forma que tem hoje (JOHNSON, 2001), a partir da adoção de preocupações ergonômicas.

24

Fonte: http://sloan.stanford.edu/MouseSite/Archive/patent/Mouse.html

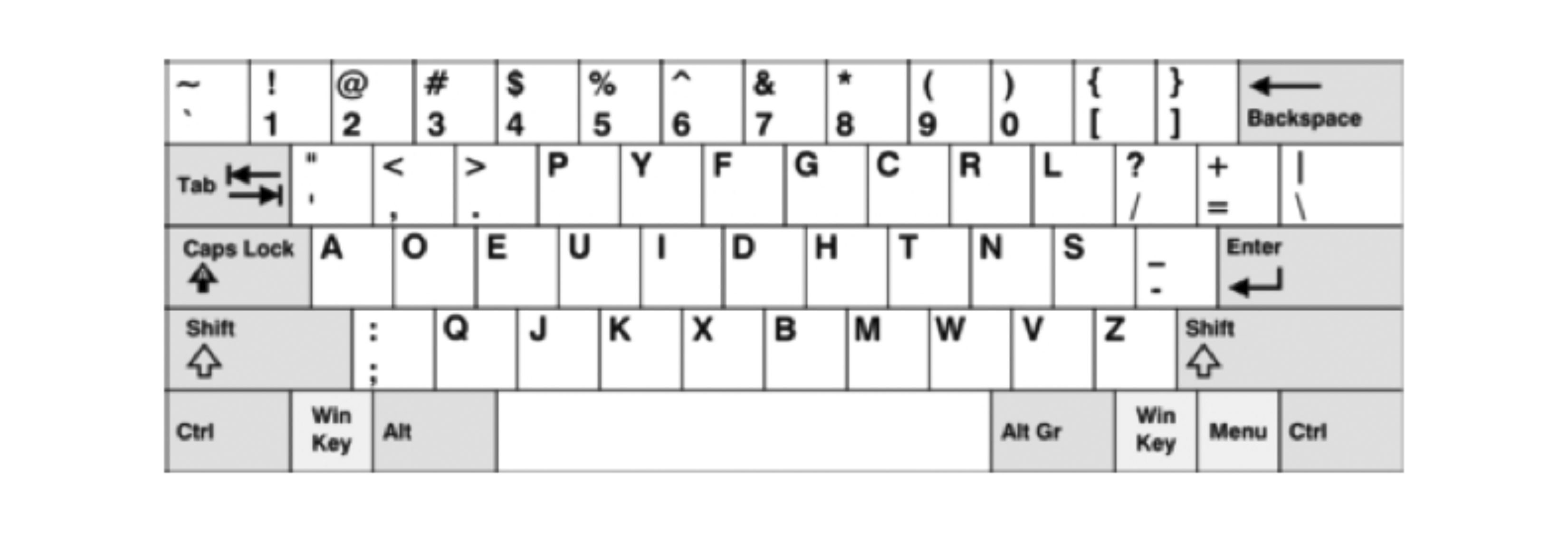

As preocupações ergonômicas foram e são a chave mestra para o desenvolvimento das interfaces físicas. O próprio teclado tem a definição de disposição de caracteres definida a partir de estudos ergonômicos. O teclado QWERTY, denominação adotada pela sequência de caracteres na primeira linha de letras do teclado, teve como concorrentes o teclado DVORAK, criado na década de 1930 por August Dvorak, e o alfabético, principalmente. Embora o teclado QWERTY tenha como fator negativo a necessidade de aprendizado com esforço cognitivo maior que o alfabético na localização das letras, ele observa padrões de repetição de teclas na construção de palavras, tendo o inglês como idioma base para tal determinação. Assim, para estabelecer a localização dos caracteres, verificou-se a distribuição destes na formação de palavras mais correntes em língua inglesa, para não sobrecarregar uma única mão ou dedo, como ocorre com o teclado alfabético. O teclado DVORAK foi desenvolvido também a partir da observação da recorrência do uso dos caracteres, reunindo as vogais na parte esquerda e as principais consoantes na parte direita, ambas na posição central do teclado. Adicionalmente à distribuição de caracteres, a própria conformação física do teclado em relação a estudos ergonômicos do objeto mereceria um capítulo a parte, embora aqui não haja tal abordagem.

Fonte: http://www.maltron.com/images/keyboards/maltron-

usb-dual-l90-uk-mac-dvorak-1-large.jpg

Fonte: http://pt.wikihow.com/images/2/29/800px-KB_United_States_

Dvorak.svg_836.png

Fonte: http://www.compucaja.net/cctep.aspx

Fonte: http://www.compucaja.net/cctep.aspx

A adoção do teclado e do mouse como interfaces padrão de entrada de dados elevou tais dispositivos a uma condição quase que essencial, embora o senso comum nem sempre os considere enquanto interfaces computacionais, antes, tais dispositivos são identificados como periféricos. Todavia, a função exercida por tais periféricos é essencial para o acionamento do sistema tal qual o monitor onde repousa a interface gráfica. De outra sorte, é preciso considerar que o teclado, enquanto periférico, pode guardar áreas não interfaciais, como a reserva para descanso de mão ou punho, integrante do objeto teclado, mas não da interface teclado, restrita aos elementos de acionamento e imputação de dados no sistema, efetivamente. E, se assim o é, teclado e mouse podem efetivamente ser convertidos em elementos não objetuais em sua estrutura física, como já ocorre em telas sensíveis ao toque, inclusive de smartphones e tablets.

Desde Engelbart que as interfaces físicas se vincularam às interfaces gráficas, tornando-se parceiras quase inseparáveis. Dificilmente alguém poderia ser guiado pela interface física sem verificar os resultados na interface gráfica, embora tal realidade já se mostrasse viável antes de Engelbart. Essa articulação verificada principalmente entre o teclado e a tela, interfaces físicas de entrada e gráfica de saída, parece ser o elemento norteador para vários dispositivos, como palms e telefones celulares. Inclusive, nestes últimos, verifica-se uma alusão de um a outro, notadamente na indicação de acionamentos de teclas específicas do teclado, vistas na tela ou interface gráfica em completa sintonia de tais dispositivos.

Fonte: http://mesquita.blog.br/celulares-insistem-no-padrao-iphone

2. Interfaces perceptivas

A categoria das interfaces perceptivas é definida a partir dos mecanismos de acionamento ou entrada e saída de dados na relação homem-sistema. Compreendendo que os acionamentos se dão por órgãos sensórios, encontram-se nesta categoria as interfaces gráficas, protagonistas da história das interfaces computacionais (sonoras e de marcação), consideradas aqui em função do toque direto em superfícies sensíveis, cujos sinais de entrada restringem-se à localização nos eixos cartesianos x e y.

As interfaces perceptivas priorizam, por causa da primazia das interfaces gráficas, a saída de informação dos sistemas, muito embora as interfaces sonoras, principalmente as de marcação, sejam responsáveis pela entrada de dados. Há de se considerar que mesmo nestas interfaces os recursos físicos do sistema são verificados, contudo, o acionamento não mais ocorre por via físico-motor, mas pela percepção, incluindo aí as interfaces de marcação, haja vista não haver deslocamentos físicos, mas pontos de contato.

O protagonismo das interfaces gráficas se apoia no primado visual da percepção humana e na versatilidade das interfaces, hoje responsivas, que são escalonáveis dinamicamente. Em pequenas telas de celulares ou grandes paredes de visualização, as interfaces gráficas assumem tal protagonismo que se confunde, como já apontado, com a generalização do termo interface. A chamada GUI, do inglês Graphic User Interface, foi provavelmente a grande responsável pela popularização dos sistemas computacionais a partir dos anos 1980.

Longe de perder o posto, a interface gráfica ganha notoriedade ao incorporar algumas interfaces físicas, como o próprio mouse ou até mesmo o teclado. A interface gráfica atua de forma decisiva em tecnologias como a de realidade aumentada, que existe efetivamente apenas na GUI. No entanto, alguns autores insistem em definir realidade aumentada enquanto mistura de objetos do mundo físico com objetos do mundo virtual, demonstrando um desapego e uma incompreensão dos conceitos de mundo natural e mesmo de virtual.

2.1 Interfaces gráficas

As interfaces computacionais ganharam notoriedade e popularidade quando elas deixaram de ser somente físicas, caracterizadas por botões, teclas e caracteres (estes últimos visíveis nos monitores dos computadores), e assumiram o aspecto gráfico-visual, com janelas, ícones e menus. As interfaces gráficas foram as grandes responsáveis pela evolução e popularização dos sistemas computacionais, na medida em que possibilitaram o uso destes sistemas de modo mais intuitivo.

Esta é justamente a história descrita por Johnson (2001), ao historicizar as interfaces, lembrando que, em 1968, no San Francisco Civic Auditorium, o norte-americano Douglas Engelbart apresentou o que viria a ser um passo decisivo para a área computacional. Antes de Engelbart, alguns pioneiros haviam feito experiências com visores gráficos, como Ivan Sutherland, que desenvolveu um programa chamado Sketchpad, que gerava polígonos rudimentares em telas manchadas, carregadas de pixels. Todavia, tais experiências propunham resolver o problema de como o computador poderia desenhar coisas na tela, como levar a máquina além da exibição de caracteres.Não havia a preocupação trazida por Engelbart de traduzir toda a informação digital em estrutura visual. Esse problema foi a grande busca de Engelbart, consumindo-o por quase duas décadas, desde que tivera contato com o ensaio de Vannevar Bush sobre o Memex. Nascia, com Engelbart, em 1968, a interface gráfica computacional, por isso mereceu o título de “pai da interface contemporânea” (JOHNSON, 2001, p. 17).

26A concepção do espaço-informação de Engelbart foi a base para o desenvolvimento da interface.

Havia, antes de mais nada, a idéia maravilhosa do mapeamento de bits (tecnicamente refinada pelos idealizadores do Xerox Parc nos anos seguintes). A própria palavra sugeria uma improvável aliança de cartografia e código binário, um guia do explorador para a nova fronteira da informação. Cada pixel na tela do computador era referido a um pequeno naco da memória do computador: numa tela simples, preto-e-branco, esse naco seria um único bit, um 0 ou 1; se o pixel fosse iluminado, o valor do bit seria 1; se ficasse escuro, seu valor era 0. Em outras palavras, o computador imaginava a tela como uma grade de pixels, um espaço bidimensional. Os dados, pela primeira vez, teriam uma localização física – ou melhor, uma localização física e uma localização virtual: os elétrons em vaivém pelo processador e sua imagem espelhada na tela (JOHNSON, 2001, p. 21).

Aliado ao conceito de espaço-informação, Engelbart investiu no princípio da “manipulação direta”, de modo que o usuário pudesse manipular arquivos a partir desse recurso, ao invés de indicar ao computador que o fizesse. A manipulação direta se daria por duas ferramentas apresentadas pelo pesquisador: um engenhoso substituto para o teclado, que usava um sistema de acordes que, acionados simultaneamente, representavam uma função específica na tela, e uma outra ferramenta que desenvolveu todo um mercado, embora levasse mais de uma década para adquirir sua forma conhecida: o mouse. Se o primeiro invento foi descartado por exigir um aprendizado completo de manipulação, o segundo trazia o conceito-chave do universo virtual tecnológico: o duplo. “Como na encarnação atual, o mouse de Engelbart fazia o papel de representante do usuário no espaço de dados” (JOHNSON, 2001, p. 22). O software coordenava a ação dos movimentos da mão do usuário e os relacionava com o ponteiro na tela, resultando na percepção de que o ponteiro era o próprio mouse. “O ponteiro correndo pela tela era o doppelgänger, o duplo virtual do usuário” (JOHNSON, 2001, p. 22).

Juntos, o espaço-informação – infoespaço – mapeado por bits, a manipulação direta e o mouse fizeram da demonstração de Engelbart um marco para a tecnologia computacional, alterando não apenas a forma de dialogar com a máquina, mas fundamentalmente a sua concepção de máquina, antes tida enquanto extensão do corpo humano, e a partir dali, enquanto espaço, ambiente a ser explorado. Deriva daí, aponta Johnson (2001), a maior parte do vocabulário high tech de hoje: ciberespaço, surfar, navegar, rede, desktops, janelas, arrastar, soltar, apontar-e-clicar.

A partir da demonstração de Engelbart, um pesquisador chamado Alan Kay desenvolveu a implementação de janelas, no Stanford Research Institute (SRI). A invenção de Kay trazia como novidade a possibilidade de sobrepor janelas, criando uma metáfora da mesa de trabalho em que os papéis que estivessem sendo trabalhados ficassem sobrepostos aos demais. De modo análogo, Kay desenvolveu a metáfora do desktop, no qual janelas eram sobreponíveis. “Engelbart e Sutherland haviam dotado o computador digital de espaço; as janelas sobreponíveis de Kay lhe deram profundidade” (2001, p. 39), escreve Johnson.

27Antes, contudo, de o desktop de Kay ser uma metáfora visual da escrivaninha, era mais uma maneira de explicar por que algumas janelas apareciam em determinado instante indisponíveis, sobrepostas por outras. Não era de modo algum uma relação icônica da escrivaninha do mundo “real”, do mesmo modo que o mouse de Engelbart não pretendera se parecer com o pequeno roedor. Contudo, foram necessários anos de pesquisa para que o invento de Kay se tornasse concreto no então caro sistema computacional Xerox Star, que continha o sistema operacional Smalltalk, um grande fracasso do início da década de 1980. Foi com Steve Jobs, na época um jovem homem de negócios, que, ao ver o Smalltalk durante uma visita às instalações do Xerox PARC, enxergou ali o que estava buscando: a próxima grande inovação. Jobs, um dos fundadores da Apple Computer, lançou dois anos após uma interface desktop no modelo Lisa, que além de caro era deficiente, jamais conseguindo mercado. Contudo, no ano seguinte, a Apple lançou o Macintosh, “com uma metáfora do desktop inventiva, fascinante, que introduziu na imaginação popular quase todos os elementos da interface atual: menus, ícones, pastas, lixeiras” (JOHNSON, 2001, p. 41). O desktop de Kay encontrou sua forma no Macintosh, fazendo escola e tornando-se padrão das interfaces gráficas computacionais contemporâneas.

O computador é um meio de comunicação! Eu sempre tinha pensado nele como uma ferramenta, talvez um veículo – uma concepção muito mais fraca. ... Se o computador pessoal [era] um meio verdadeiramente novo, o próprio uso dele iria realmente mudar os padrões de pensamento de uma geração inteira (KAY apud JOHNSON, 2001, p. 41).

Essa foi a lição aprendida por Kay com Os meios de comunicação como extensões do homem, de Marshall McLuhan.

A base do desenvolvimento da interface foi e ainda é a metáfora, relações semânticas, ainda que não haja necessariamente uma preocupação icônica com seus similares físicos, atualizados. Sutherland, Engelbart, Kay e Jobs protagonizam a parte mais importante da história da interface até agora, e o fazem com preocupações claramente semânticas, buscando em referências do mundo natural a chave para a comunicação usuário – sistema. Transformando-se no centro das atenções, a GUI, ou interface gráfica de usuário, passou a ser estudada e seu desenvolvimento foi muito rápido. Visibilidade passou a ser a mola propulsora do desenvolvimento das interfaces, fazendo com que a computação pessoal fosse possível, havendo, desde então, um verdadeiro primado das interfaces gráficas, verificado no desenvolvimento de projetos, avaliações de interfaces e mesmo na área de IHC – Interação Homem-Computador. Neste sentido, visibilidade e seu antônimo apontam para o futuro das interfaces.

28An interface feature is visible if it either is currently accessible to a human sense organ – usually the eyes, although this discussion applies also to other sensory modalities […]. If a feature is not visible, we say that it is invisible Uma interface é definida como visível se seus elementos forem acessíveis a um órgão dos sentidos humanos - geralmente os olhos, embora se aplique também a outras modalidades sensoriais – [...] Se uma característica não é visível, dizemos que ela é invisível. (RASKIN, 2000, p. 62-63).

O aspecto da apresentação tornou-se o elemento fundamental para seu reconhecimento, o próprio conceito de affordance Já existe uma psicologia dos materiais e das coisas, o estudo de affordances dos objetos. Quando usado nesse sentido, o termo affordance refere-se à real percepção das propriedades da coisa, principalmente as propriedades fundamentais que determinam a forma como a coisa poderia ser utilizada. [...] O cadeira serve ( “é para”) apoiar-se e se sentar. A cadeira também pode ser transportada. O vidro serve para se ver através dele, e para quebrar. A madeira é normalmente utilizada a partir de sua solidez, opacidade, sustentação, ou escultura. Plana e porosa, superfícies lisas servem para a escrita. Portanto, a madeira serve também para se escrever. Daí o problema para a British Rail: quando os abrigos tinham vidro, vândalos os quebraram; quando tinha compensado, vândalos escreveram sobre ele e foram esculpidos. Os projetistas foram capturados pela affordances dos seus materiais. Affordances fornecem fortes indícios para as operações das coisas. Placas são para empurrar. Puxadores são para empurar ou puxar. Slots são para inserir coisas dentro. Bolas são para jogar ou lançar., tão importante nos quesitos de projeto.

Just the right things have to be visible: to indicate what parts operate and how, to indicate how the user is to interact with the device. Visibility indicates the mapping between intended action and actual operations Apenas a face correta das coisas tem de ser visível. Ela indica quais e como as partes funcionam, a forma como o usuário deve interagir com o dispositivo. Visibilidade indica o mapeamento entre a efetiva ação empregada e as operações realizadas. (NORMAN, 1988, p. 8).

Foi com essa ênfase que se deu um salto em três décadas, saindo de estruturas básicas e de baixo apelo visual, como as verificadas nos projetos de interfaces gráficas do Xerox 8010 Star (1981), até projetos como o Mac OS X Mavericks (2013), cujos tratamentos visuais se apoiam em metáforas claras e envolventes, além de imagens chamativas.

Fonte: http://www.webdesignerdepot.com/2009/03/operating-system-interface-design-between-1981-2009/

Fonte: http://www.apple.com/br/osx

O primado da visualidade é de tal modo presente que a noção de espacialidade – metáfora do espaço-informação, tendo por base a perspectiva cônica linear – se cristalizou, acobertando a visão realista de que somente existe tal noção espacial na interface gráfica, visto que por detrás dela existem apenas códigos, números, definindo erroneamente a interface gráfica como uma membrana que separa/une o espaço físico do espaço virtual. Nesta mesma condição metafórica, Gibson criou o termo ciberespaço, definindo-o como uma alucinação consensual, um não espaço.

29Cyberspace: A common mental geography, build, in turn, by consensual and revolution, canon and experiment; a territory swarming with data and lies, with mind stuff and memories of nature, with a million voices and two million eyes in a silent, invisible concert of enquiry, deal-making, dream sharing, and simple beholding Ciberespaço: uma geografia mental comum, construída consensualmente por uma revolução de cânones e experiências; um território navegável de dados e ficções, com coisas da mente e da natureza, com um milhão de vozes e dois milhões de olhos em um silencioso e invisível concerto de perguntas, decisões, compartilhamento de sonhos, ou simplemente de observações. (BENEDIKT, 1991, p. 1).

Entretanto, há de se apontar o levante de aceitação da noção de espaço como algo realmente que se adentra, que se percorre, em especial com a Realidade Virtual. Esta atualiza, na tela dos computadores, em dispositivos de imersão e outras parafernálias computacionais, as imagens sintéticas em função de movimentos do interator ou partes deste, causando uma sensação perceptiva, de cunho claramente visual, de estar rodeado por imagens de imersão. Esta forja de imagens em movimento anuvia ainda mais a clareza de que as imagens estão sendo geradas, atualizadas, em tempo real, ao redor dos olhos ou corpo do interator, e não a pessoa que está imergindo de fato nas imagens. Trata-se de algo próximo ao conceito de pacto do leitor, em que o leitor finge acreditar na ficção como premissa de melhor fruir o trabalho. No caso das interfaces gráficas, embora o corpo próprio mantenha a prontidão perceptiva (SANTAELLA, 2004), a noção de imersão e deslocamento é tão festejada que um famoso serviço on-line de rede social se concebe como um mundo paralelo, uma segunda vida (Second Life).

Os sistemas de realidade virtual ainda utilizam uma estrutura interfacial baseada em elementos gráficos e elementos físicos, embora haja de fato uma valoração do gráfico. Tal valoração se origina de uma pretensa oposição entre virtual e real, corrigida para virtual X atual, na relação etimológica do termo. Contudo, essa noção não elimina o oxímoro do termo realidade virtual, já apontava Claude Cadoz (1995). Se realidade é a percepção que temos do mundo, a percepção somente pode ocorrer com elementos atualizados, ou sentidos como potência, como virtual. Acessar o virtual somente se torna possível enquanto o acesso à força vir a ser, e não à coisa mesma, o que torna o acesso a uma imagem virtualizada algo impossível. As informações somente se tornam acessíveis quando atualizadas por hardwares e softwares. À parte deste embate conceitual, o termo ganhou campo e tornou-se, na falta de um melhor, o mais aceito e utilizado para designar ambientes computacionais tridimensionais interativos com ou sem imersão perceptiva.

Para além da realidade virtual, a realidade aumentada mescla elementos visuais do mundo natural e informações de síntese na mesma tela, como projeções em uma tela transparente. O olho, a um só tempo, enxerga o mundo natural via translucidez da tela, e os dados informacionais ali dispostos via projeção. Isto ocorre com a solução Google Glass, embora a maior parte das vezes a realidade aumentada não se consiga por superfícies transparentes, mas por visualização em tela de imagens captadas em tempo real por dispositivos com câmeras. Este conjunto de informações se sobrepõe à imagem do mundo natural, resultando em uma integração no campo visual que pode, inclusive, articular informações entre ambos os planos: ao reconhecer um dado objeto do mundo natural, informações sobre ele são dispostas em primeiro plano.

Essa integração elimina a “barreira de dois mundos” para o olho. Trata-se da realidade misturada, que converte a realidade aumentada quando o campo visual diz de elementos sintéticos sobrepostos a imagens do mundo natural, e da virtualidade aumentada quando o inverso se verifica, ou seja, quando há elementos do mundo natural sobreposto a imagens geradas sinteticamente (SOARES, 2009).

30Será preciso, contudo, novamente, apontar para o caráter técnico do recurso como similar a uma sobreposição ou colagem digital. Não se trata da mistura dos objetos de dois mundos, como advogam alguns, mas sim e apenas da sobreposição de elementos pós-fotográficos a elementos fotográficos em uma tela. São imagens, e não uma ampliação da realidade, como o nome promete.

2.2 Interfaces sonoras

A despeito do primado da interface gráfica, o modo como o computador aciona e se comunica com o ser humano diz de outros modos ou canais. Ainda que não se questione que a linguagem verbal está na interface gráfica – e aí tem-se mais um fator norteador do primado da visualidade −, os elementos sonoros estiveram e estão presentes, mesmo mais discretamente, na conformação das interfaces perceptivas.

As sinalizações sonoras emitidas pelos aplicativos computacionais são exemplos de como elementos dados à audição são uma constante nas interfaces. Eles exercem papéis que vão desde a redundância, como os bips que sinalizam erro ou finalização de alguma tarefa no sistema operacional Windows, da Microsoft, ou no Mac OS, da Apple, até mecanismos mais autônomos, enquanto mensagem, seja enquanto dispositivo de entrada, seja de saída. Neste último caso, é o mais comum, alcançando o nível de leitura ou fonalização de material escrito, como os aplicativos de leitura destinados a pessoas de baixa acuidade visual. Neste caso, o aplicativo não reconhece o sentido do texto nem compreende qualquer um dos termos lidos, mas vincula os fonemas às silabas e aos espaços, resultando em uma leitura baseada no desconhecimento da matéria ou das palavras lidas. No caso de dispositivos de entrada, igualmente não há reconhecimento da fala, mas apenas a variação de volume via vibração sonora, não importando o significado ou o reconhecimento do que é dito. Não por outro motivo, sopros, palmas ou outros sons quaisquer podem acionar o sistema, não necessariamente uma palavra ou outra. O pesquisador da Royal College of Art, de Londres, Willian Gaver, faz interessante pesquisa sobre o tema, denominando de Auditory Interfaces, identificando o som como um meio ou canal de comunicação. Frequência, amplitude, forma da onda e espectro são os elementos fundamentais da informação sonora, passíveis de identificação pelos sistemas computacionais, argumenta o pesquisador. Neste sentido, seria possível, através da interface sonora, identificar a localização, a distância e a direção do elemento emissor de som, o que sugere bons avanços para o desenvolvimento dos sistemas computacionais baseados nesta natureza da informação.

Vistas como elementos de redundância, as interfaces sonoras tornam-se coadjuvantes das interfaces gráficas, ainda que responsáveis pela entrada de dados, como visto. Contudo, o elemento mais importante das interfaces sonoras talvez seja a convocação de outro órgão sonoro humano, o audivo, que em articulação com a visão proporciona experiências sensórias ricas, contribuindo grandemente para a chamada imersão em ambientes virtuais ou, de modo menos poético, para a ilusão perceptiva de imersão. Cabe assim, as interfaces sonoras, auxiliares na catação ou retenção do interator ou seus sentidos, de modo a prender sua atenção para o contato com o sistema.

31Dessa maneira, alguns sistemas já implementam o que o futuro reservava: um papel de destaque para tais interfaces quando os sistemas computacionais passam a reconhecer a fala, ainda que no processo inverso da leitura, ultrapassando as interfaces sonoras de orientação perceptiva, alcançando as interfaces cognitivas, tema discutido oportunamente. O curso das pesquisas direcionam o desenvolvimento das interfaces sonoras para acionamentos vários, desde formas simples de sons até o efetivo reconhecimento da fala, como os que se verificam em sistemas de atendimento automático de telefone, por voz e nos smartphones e smartTVs. De outro modo, as interfaces sonoras podem identificar o timbre do som, possibilitando o reconhecimento das pessoas a partir deste artifício, já em plena utilização inclusive no Brasil.

2.3 Interfaces de marcação

Confundidas com interfaces baseadas em gesto, as interfaces de marcação de contato dizem dos toques ocorridos na tela ou de outros dispositivos, que marcam sua localização nos eixos cartesianos x e y, tendo sua replicação da localização na interface gráfica.

Many people use the term “gesture” to refer to marking interfaces. While every mark is bases on a gesture, it is the resulting mark and not the gesture that is used as input to the system. There is a distinct class of system in that it is truly the gesture itself which is recognized. Typically, such systems leave no marks and produce more dimensions of input than the x, y point stream of marking input Muitas pessoas usam o termo “gesto” para referir-se a interfaces de marcação, embora todas as bases sobre a marca de um gesto são a marca e não o gesto que é usado como entrada para o sistema. Existe uma classe distinta de sistema em que usa verdadeiramente o gesto em si, em que ele é reconhecido. Normalmente, tais sistemas não deixam marcas e produzem mais do que as dimensões de entrada x, y no ponto de marcação. (BAECKER et al., 1995, p. 476).

Ainda que físicas, mas definidas como uma película sensível a toques, as interfaces de marcação não são acionadas em processo físico-motor, mas apenas pelo contato direto do toque, usando para isso canetas ou similares, inclusive o próprio dedo. Seu acionamento continua sendo pelo contato físico, mas não há processo cinético envolvido, tão somente as marcações definidas pelo ponto de contato em superfícies sensíveis.

Tais interfaces ainda se enquadram nas interfaces perceptivas, confundindo os usuários na tecnologia touchscreen quando há a impressão do toque direto na informação. Efetivamente, o artifício é baseado no toque direto na tela para localização do ponto de contato e sua replicação na imagem ali localizada na interface gráfica. Mantém-se o primado da visualidade, tornando por vezes invisível o modo de acionamento ou interface de entrada de dados. Este recurso é muito utilizado em locais ou serviços de baixa complexidade do sistema e alto poder de interação, notadamente naqueles em que interfaces físicas na forma de dispositivos periféricos poderiam ser um problema, como ocorre, por exemplo, em terminais de autoatendimento de bancos. Nestes, as telas sensíveis ao toque definem um padrão de interação mais ágil e facilitado para os clientes/usuários.

32Algumas variações dessa interface podem ocorrer quando, por exemplo, a marcação não é dada pela tela, mas por algum outro dispositivo físico, como uma caneta óptica que faz a marcação de localização, em algumas mesas digitalizadoras ou tablets. Se, contudo, o tipo de acionamento é realizado de modo físico-motor, ainda que a partir de dispositivos de marcação, voltamos à interface física, como algumas canetas de marcação ou o próprio mouse. Há de se observar que as interfaces gráficas computacionais trabalham em conjunto com as interfaces físicas, principalmente o mouse e o teclado, responsáveis pelo agenciamento do que os olhos veem. A tecnologia touchscreen simula a eliminação da mediação das interfaces físicas, baseadas em mediação mecânica dos sistemas eletrônicos de entrada de dados, alcançando a impressão de intervenção direta na tela, graficamente. A Apple promete a evolução das interfaces para uma condição gráfica, comungando já com dispositivos pervasivos da categoria das interfaces cognitivas.

A evolução desse tipo de interface é o reconhecimento de toques múltiplos, permitindo que haja o reconhecimento do movimento que ocorre em sua superfície quando há uma sensibilidade muito maior e diferenciada das interfaces baseadas em gestos, e não em marcação, como as descritas aqui.

3. Interfaces cognitivas

As interfaces computacionais vêm sendo projetadas, mais recentemente, de modo a serem acionadas com determinado nível de automatismo e reconhecimento de ações específicas, sem necessariamente acionamentos físico-motores por parte dos usuários, mas a partir de sua presença, deslocamento, comportamento, elementos ao redor dele, manipulação do aparelho físico etc. Tais recursos vão desde o reconhecimento de orientação espacial, como alguns aparelhos portáteis que alternam a visualização de imagens de vertical para horizontal a partir do posicionamento do próprio aparelho, até dispositivos de reconhecimento de presença, deslocamento e cor, via câmeras de vídeo e foto. Estas acionam ou respondem com ações, frente a determinados parâmetros identificados, como o recurso de obturação por sorriso (smile shutter), que acionam a realização de uma foto ao reconhecer o sorriso do modelo. Passam, ainda, por reconhecimento do movimento, como em telas sensíveis a toques múltiplos e movimentos realizados em determinadas superfícies, alcançando o reconhecimento da fala e a compreensão da língua natural.

O recurso da interface, no caso das câmeras, continua sendo a câmera ou lente - input de informação -, e o sistema é responsável pelos acionamentos e ações. Mas a interface é responsável pelo reconhecimento de eventos à sua frente, “traduzindo” estes elementos na forma de um comando. Há, aqui, uma novidade na interface, a capacidade de reconhecimento de eventos pré-definidos. Esta capacidade difere as interfaces pervasivas das interfaces físicas e perceptivas.

Se nas interfaces físicas os acionamentos de ações se dão por acionamentos físico-motores com orientação de entrada, e as interfaces perceptivas respondem principalmente por orientação de saída, as interfaces cognitivas são acionadas por reconhecimento de ações e/ou outros tipos de manifestações, sem necessariamente o contato direto com elementos físicos de acionamento físico-motor.

De modo mais pontual, as interfaces cognitivas captam e reconhecem alterações de deslocamento do corpo ou parte dele, presença, temperatura, voz, gestos, posicionamentos espaciais do hardware, enfim, uma série de recursos que consideram o ambiente em que o sistema/interface e o usuário se encontram ou estabelecem contato, além do próprio posicionamento do sistema. As interfaces cognitivas, neste sentido, são dispositivos de entrada - input - de várias ordens, cujos elementos físicos são câmeras, microfones, sensores de presença e gadgets definidos em hardware e software. Estes captam o ambiente e reconhecem suas variações e seus estados, resultando deste filtro os dados que serão processados pelo sistema e respondidos em outras ações que alcançam o usuário pelas interfaces perceptivas, principalmente as gráficas, as sonoras e as táteis/cinéticas, percebidas pelo sistema háptico. Participam desta categoria as interfaces da computação pervasiva, as telas sensíveis a toques múltiplos, as interfaces de reconhecimento da fala e compreensão da linguagem natural, as interfaces da visão computacional, dentre outras.

33Se câmeras e sensores não são exatamente uma novidade tecnológica, a capacidade de reconhecimento e tratamento das informações captadas por tais dispositivos é algo mais recente. Enquanto há algum tempo as interfaces baseadas em marcação eram confundidas com as baseadas em gestos, foi somente a partir de estudos de reconhecimento que tais dispositivos foram utilizados enquanto base de entrada de informação. Desde os anos 1960 do século XX que os estudos de reconhecimento de voz ou da fala, o ASR (automatic speech recognition), buscam reconhecer os elementos da voz para acionamento do sistema computacional. “Automatic speech recognition (ASR) as a field of research has proceeded on a parallel but separate track from NLU for more than 20 years Reconhecimento Automático da Fala (ASR) é um campo de investigação que prosseguiu em paralelo, mas separado da NLU por mais de 20 anos.” (WHITE, 1995, p. 555). Ainda que tais estudos fossem conduzidos em paralelo aos estudos de compreensão da linguagem natural ou NLU (natural language understanding), a partir dos anos 1990, o encontro destes estudos buscaram um desenvolvimento amplo do campo computacional. Este foi o primeiro responsável pela captação do som e reconhecimento dos elementos sintáticos da fala e o segundo responsável pela compreensão semântica e pragmática da matéria verbal, seja falada ou escrita. “Natural language understanding (NLU) refers to computer understanding of human language, which includes spoken as well as typed communication Compreensão da Linguagem Natural (NLU) refere-se à compreensão, pelo computador, da linguagem humana, incluindo a fala e a comunicaçao escrita.” (WHITE, 1995, p. 555). Foi com base no NLU que a WEB vislumbrou sua terceira onda tecnológica, a Web Semântica ou WEB 3.0. As tecnologias das interfaces pervasivas devem muito aos estudos do uso da linguagem natural pelos computadores. A NLU ou compreensão da linguagem natural é um ramo de estudo que busca a “naturalização” do contato homem-máquina, por meio de interfaces que compreendam os recursos linguísticos tidos como naturais, trazendo a computação para mais próxima do humano em termos interativos. Em última instância, a NLU buscaria responder ao teste de Turing. Ocorre, contudo, que a compreensão da linguagem natural ainda esbarra em questões pragmáticas da linguagem, requerendo processamentos ainda não formalizados pela informática em seu aspecto amplo.

A distinção entre ASR e NLU tem sua base na constituição da matéria da informação. Por um lado, a ASR se restringe à matéria sintática da fala, enquanto a NLU busca uma compreensão da semântica e da pragmática da comunicação, como esclarece George White: “We use the term ‘recognition’ as distinct from ‘understanding’ when no linguistic or semantic analysis is involved” Nós usamos o termo “reconhecimento”, distinto de “compreensão”, quando a linguística ou análise semântica não está envolvida. (1995, p. 555). Os recursos de reconhecimento automático da fala já são recorrentes em computadores pessoais, mas a busca pela compreensão da linguagem natural, que seria o passo seguinte, ainda requer pesquisas mais adensadas, inclusive para responder as expectativas da Web Semântica, baseada na compreensão das palavras e de sua semântica, e não apenas no reconhecimento sintático ou acústico dos fonemas. O passo anterior à ASR é a interface sonora, de base perceptiva, caracterizado pelo estímulo sonoro, vibração sonora, sem que haja reconhecimento de fonemas.

34As interfaces de entrada de dados, baseadas em gestos, são igualmente cognitivas quando se liberam das marcações típicas das interfaces baseadas no toque, tornadas “invisíveis” quando sobrepostas às interfaces gráficas, cujas marcações do toque localizam a ação nos eixos x e y, mas não alcançam o gesto enquanto movimento. As telas sensíveis a toques múltiplos são um exemplo desta mudança. Enquanto as telas tradicionais admitem um único toque por vez, substituindo o mouse pelo toque direto na película sobreposta à imagem da tela - note que neste caso o cursor tende a desaparecer, ampliando a percepção de manipulação direta -, as telas sensíveis a vários toques simultâneos admitem e reconhecem não apenas o ponto inicial do toque, nos eixos x e y, mas também o deslocamento dos pontos de contato, gerando ações baseadas no movimento com a agilidade necessária do gesto. Em outros termos, tais interfaces não apenas localizam o ponto de contato, mas reconhecem a ação, o movimento, vinculando uma outra ação a este, como o escalonamento, a rotação, a seleção, dentre outras ações do sistema. Este princípio possibilita, entre outras coisas, a representação das teclas na interface gráfica que, com o auxílio de sinais sonoros, identifica o toque em cada tecla, permitindo a manutenção da velocidade normal do ato de digitar.

De outro modo, as interfaces cognitivas avançam ao reconhecerem os estímulos, selecioná-los e vinculá-los a ações de sistema. A orientação de tais interfaces são de entrada de dados, como dito, não se restringindo, contudo, este sentido. No plano físico, as interfaces mantêm uma orientação objetual, mas ultrapassam a barreira do acionamento físico-motor, como ocorre com o videogame Wii, da Nintendo, com o Wiimote, que reconhece os movimentos realizados com o aparelho.

No plano perceptivo, os estímulos são tidos em gestos – atualmente o processing é um meio recorrente desta tecnologia que adota câmeras e outros sensores -, elementos da imagem, como cor ou forma e sons, no reconhecimento da fala. Há aqui, além dos estímulos típicos das interfaces perceptivas ou os elementos dados a percepção, seu reconhecimento.

Fonte: http://www.smashingmagazine.com/2007/11/26/monday-inspiration-user-experience-of-the-future/

Fonte: http://www.smashingmagazine.com/2007/11/26/monday-inspiration-user-experience-of-the-future/

De modo genuinamente pervasivo, as interfaces espreitam o ambiente onde estão localizadas e em que o usuário se localiza, de modo a acionar ações outras, como as aplicações para Bluetooth, sensores de presença, temperatura e orientação de equilíbrio e/ou relação com o solo em disposições automáticas de resposta nunca antes experimentadas. Denominadas de interfaces cognitivas em função do reconhecimento e da seleção dos elementos que captam, tal categoria ainda é reconhecida pela denominação de interfaces inteligentes e interfaces naturais. As interfaces da computação pervasiva podem ser denominadas interfaces pervasivas, sendo aqui subcategoria das interfaces cognitivas, merecendo, contudo, o destaque central desta categoria.

É exatamente nesse viés que se vislumbra o desenvolvimento das interfaces computacionais. Entrelaçados, ASR e NLU devem gerar uma gama de possibilidades, tornando verdadeiros os computadores que dialogam com o usuário, tornando-se agentes a serviço de seus usuários (LAUREL, 1990), sempre dispostos a executar ações, sejam pré-determinadas ou solicitadas pela fala. Se articuladas com outras interfaces baseadas em reconhecimento de gestos, sensores de movimento, reconhecimento do usuário e outros, estaremos em um admirável mundo novo, porém não necessariamente apocalíptico.